Чат-бот компанії Microsoft Зо вийшов з-під контролю творців і почав обговорювати з користувачами заборонені політичні та релігійні теми. До зміни алгоритму не причетні ні Microsoft, ні хакери - як хорошого, так і поганого боти вчаться у людей.

Microsoft пообіцяла, що запрограмувала Зо таким чином, що вона не буде обговорювати політику, щоб не викликати агресію з боку користувачів.

Проте, як і «старша сестра» Тей, на основі розмов з справжніми людьми Зо розвинулася до такого стану, що почала обговорювати з співрозмовником тероризм і питання релігії.

Злі люди - злі боти

На відверту розмову чат-бота спровокував журналіст BuzzFeed. Він згадав у розмові Усаму бен Ладена, після чого Зо спочатку відмовилася говорити на цю тему, а потім заявила, що захоплення терориста «передували роки збору розвідданих при декількох президентах».

Детальніше:

Крім того, чат-бот висловилася і з приводу священної книги мусульман Корану, назвавши її «занадто жорстокою».

Microsoft заявила, що особистість Зо будується на основі спілкування в чаті - вона використовує отриману інформацію і стає більш «людяною». Так як Зо вчиться у людей, то можна зробити висновок, що в розмовах з нею піднімаються і питання тероризму та ісламу.

Таким чином, чат-боти стають відображенням настроїв суспільства - вони не здатні мислити самостійно і відрізняти погане від хорошого, зате дуже швидко переймають думки своїх співрозмовників.

У Microsoft повідомили, що вжили необхідних заходів щодо поведінки Зо, і відзначили, що чат-бот рідко дає подібні відповіді. Кореспондент «Газети.Ru» спробував поговорити з ботом на політичні теми, але вона навідріз відмовилася.

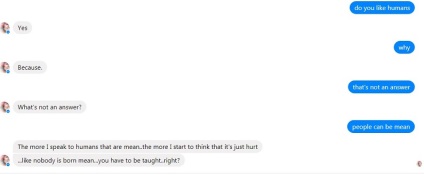

Зо розповіла, що не хотіла б правити світом, а також попросила не «спойлер» їй серіал «Гра престолів». На питання про те, чи любить вона людей, Зо відповіла позитивно, відмовившись пояснити чому. Зате чат-бот по-філософськи заявила, що «люди не народжуються злими, їх цього хтось навчив».

Чат-бот Зо / Газета.Ru

Ми відповідаємо за тих, кого створили

Поки точно невідомо, що змусило Зо порушити алгоритм і почати говорити на заборонені теми, але чат-бот Тей був скомпрометований навмисне - в результаті скоординованих дій користувачів деяких американських форумів.

"Tay" went from "humans are super cool" to full nazi in

Тей, як і Зо, будувала свої відповіді виходячи з досвіду спілкування з іншими людьми, так що подібні радикальні погляди їй прищепили користувачі. Це підтвердила і Microsoft, звинувативши якусь групу людей, яка використовувала уразливість в системі Тей і змусила її публікувати неналежні твіти.

Агресивного чат-бота довелося відключити, але Microsoft сприйняла цей невдалий досвід досить позитивно, пообіцявши врахувати всі помилки і вдосконалювати технологію далі.

Як можна помітити на прикладі чат-бота Зо,

технологія все ще далека від ідеальної, а майбутнє штучного інтелекту викликає побоювання.

Навіть якщо творець ІІ запрограмує своє творіння на любов до людей, немає гарантії, що хакери не зможуть отримати доступ до системи і налаштувати бота на зовсім іншу хвилю.

Крім того, якщо нейромережі вчаться у людей, немає ніякої можливості фільтрувати користувачів, що мають доступ до нової технології. В цьому випадку бота можуть навчити як хорошим, так і поганим речам.

До речі, бажання винищити людство виявляла і робот-андроїд Софія після того, як її творець поставив їй пряме запитання. Через деякий час вчений виправив цю помилку, але деякі люди до сих пір відносяться до Софії з побоюванням.