2-е початок термодинаміки описує деякі процеси в біологічній системі в основі яких лежать статистичні закономірності. Однак, на ряду зі статистичними процесами в організмі існують сукупність детерминистических механічних систем, для яких справедливі інші закони. Статистичні закономірності визначають статистичний стан системи, тобто ентропія є мірою невпорядкованості системи.

У стаціонарному стані ймовірність знаходження в ньому системи дорівнює 1. Використовувати поняття інформації для опису стану системи можливо, спираючись на зв'язок інформації та ентропії, встановив Шеннон. На всіх рівнях біологічної системи існує, виникає і накопичується інформація, реалізація одного з декількох можливих станів сприймається як якесь кількість інформації.

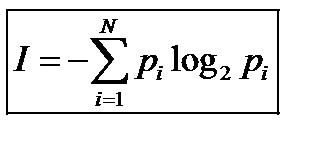

Т.ч. порівнюючи вирази для кількості інформації і ентропії, Шеннон встановив зв'язок.

Ентропія і інформація пов'язані між собою, проте такий зв'язок справедлива лише для інформації, яка не може бути замінена. Т.ч. система з будь-якого мікростану швидко переходить в інше Мікростан без збереження інформацію. Для n подій, ймовірність яких відома, кількість інформації укладеної в системі можна визначити за формулою:

В біологічній системі зі збільшенням складності виникає можливість запам'ятовування інформації про стан системи. Процес запам'ятовування вільних до перехідних систем в одне з 2-х станів, який супроводжується втратою енергії і для виходу з якого потрібно система додаткової енергії. Т.ч. збільшення інформації в складних біологічних системах пов'язаних ні з збільшенням елементів системи, а за рахунок встановлення зв'язку між елементами системи. Зі збільшенням складності системи, вимірювальна цінність інформації, тобто неможливість існування систем без інформації саме в цьому стані. Т.ч. інформаційна система організму повинна включати статистичні і динамічні інформаційні підсистеми. Статистична інформація пов'язана з фізичної ентропією і є мірою не запам'ятовує системним микростанів. Макро інформація є мірою тих станів, про перебування в яких система повинна пам'ятати.