Привіт, шановні читачі блогу Goldbusinessnet.com! Вимоги пошукових систем посилюються, і нам доводиться з цим миритися. Зараз настає новий етап, коли для досягнення максимального ефекту при просуванні сайту в Гуглі необхідно надати його роботу (Googlebot) доступ до всіх ресурсів, які так чи інакше формують відображення сторінок сайту в браузері.

Щоб виконати вимоги Гугла, необхідно все вище згадані ресурси розблокувати для Googlebot, щоб забезпечити своєму вебсайту максимальні преференції при ранжируванні в Google. Як це здійснити практично, ми і розглянемо трохи нижче.

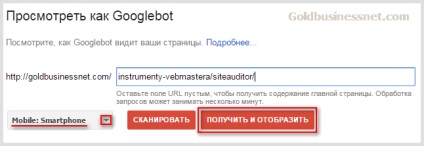

Які ресурси потрібно розблокувати для Гугл бота і навіщо це потрібно

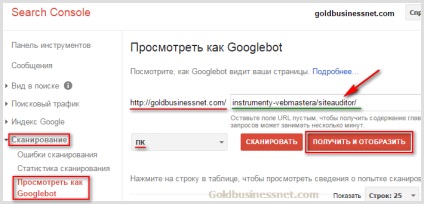

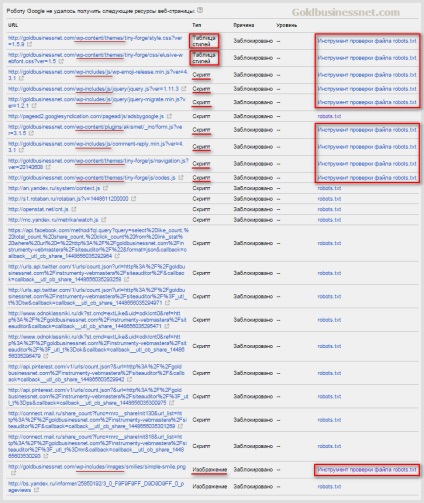

Думаю, багато веб-майстри свого часу вже отримали повідомлення від Google, початок якого було приблизно таким: «Googlebot не може отримати доступ до файлів CSS і JS. »(Англійською це звучить як« Googlebot can not access CSS and JS files. »).

Ну і далі йшло попередження про те, що в разі, якщо проблема не буде вирішена, то позиції сайту можуть серйозно постраждати. Зазвичай в подібних випадках Гугл не жартує. Тому всім, хто поки не турбувався виправити ситуацію, рекомендую зробити це найближчим часом, оскільки блокування частини файлів для бота Гугла може обіцяти неприємності.

Стилі CSS, як відомо, відповідають за зовнішній вигляд веб-сторінок, зображення є частиною, а JS скрипти визначають функціонал вебресурса. Крім того, дуже важливою частиною контенту є зображення (визначені графічними файлами), які також повинні бути відкриті для робота Гугла.

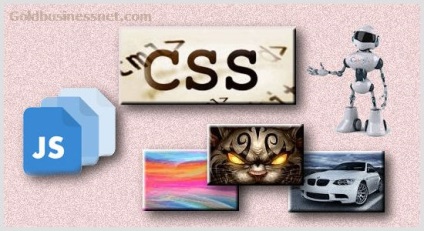

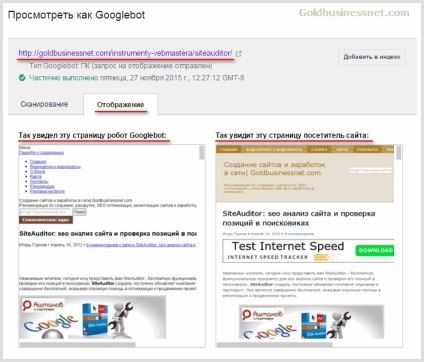

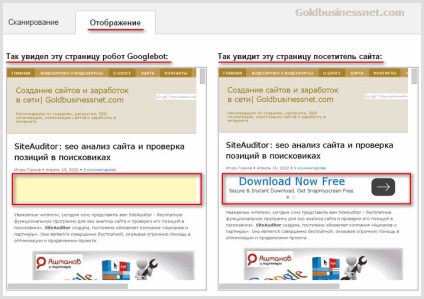

В результаті отримаєте картинки для порівняння: зліва буде вид досліджуваної вебсторінки очима бота Гугла, а праворуч - звичайного користувача (у вкладці «Відображення»):

Як то кажуть, "знайдіть 10 відмінностей". Як бачите, робот і юзер зовсім по-різному візуально сприймають дану веб-сторінку. Тому потрібно вдатися до таких дій, які б дозволили б стерти відмінності і тим самим догодити панові Google.

Після того, як ви отримаєте порівняльні скріншоти сторінки сайту для робота і для користувачів, внизу будуть представлені посилання на всі ресурси, до яких закритий доступ (зазвичай це стилі CSS, скрипти і зображення, про що я згадував вище) в файлі robots.txt ( тут повновага інформація про цей найважливіший файлі для WordPress):

Редагування robots.txt (для WordPress) з метою відкриття доступу роботу Гугла

Отже, для зняття блокування необхідних файлів потрібно відкрити відповідні позиції в Роботс. Для початку давайте проаналізуємо список URL, які були отримані після сканування одній зі сторінок мого блогу (дивіться попередній скріншот вище).

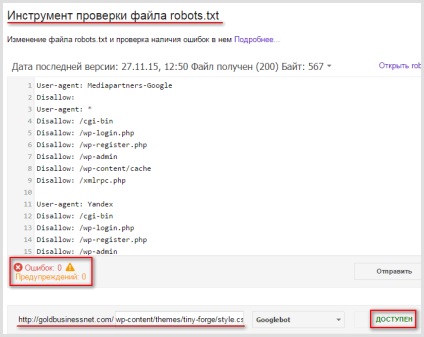

Для перших є посилання на інструмент перевірки файлу роботс.тхт. Завдяки цьому в будь-який момент можна перевірити поточний стан обраного ресурсу. Скажімо, сканування вироблено до того, як ви вжили заходів щодо виправлення ситуації, а після скоєння цих дій ви вирішили подивитися, наскільки змінилася ситуація, натиснувши на цей лінк:

Якщо все зроблено коректно, то ви побачите, що цей файл насправді тепер доступний:

Попутно можна переконатися в коректності складеного robots (відсутності помилок і попереджень). Це теж важливо і безпосередньо може вплинути на ступінь ефективності просування вашого проекту.

Гугл радить в цьому випадку звернутися до власників вебресурсів з проханням розблокувати потрібні файли. Природно, в переважній більшості випадків такий крок приречений на невдачу. Інший варіант: постаратися просто видалити зі свого сайту частину елементів, пов'язаних зі сторонніми сайтами.

Однак, всі файли, які веб-майстер в силах відкрити для робота, повинні бути обов'язково розблоковані. Тому зробимо необхідні дії лише щодо тих ресурсів, які пов'язані з власним сайтом і доступ до яких можна безперешкодно регулювати.

Якщо знову поглянути на картинку з закритими ресурсами (попередня-попередня скріншот), то можна звернути увагу, що всі вони (таблиці стилів, скрипти і зображення) знаходяться в директоріях:

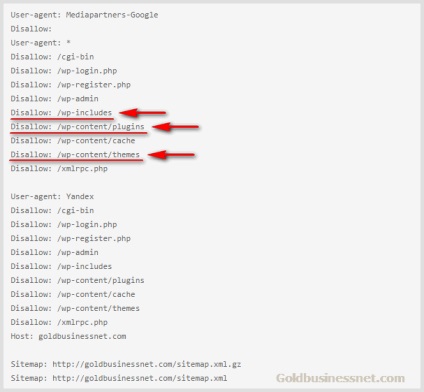

Цілком логічно, що саме до цих папок і слід відкрити Гугл боту доступ. По крайней мере, я так і зробив, хоча це досить грубий метод. Точніше, просто видалив Disallow щодо даних директорій:

Безумовно, існують і більш вишукані варіанти, наприклад, вказівка цільової роздільної директиви Allow безпосередньо для кожного ресурсу, але я не став кардинально змінювати структуру свого robots.txt, в кінці кінців результат досягнутий. Тому остаточний варіант в міру універсального файлу robots.txt для стандартного блогу Вордпресс з урахуванням останніх гугловських вказівок виглядає за моєю версією таким чином:

Хоча потрібно бути готовим до того, що це далеко не остаточний варіант. Я, наприклад, не виключаю, що Яндекс візьме приклад з свого головного конкурента і теж зажадає від власників інтернет-ресурсів щось схоже. Так що в цьому місці ставимо не крапку, а три крапки.

А ось як виглядає тепер перелік закритих для бота ресурсів: