Добрий час доби шановні читачі!

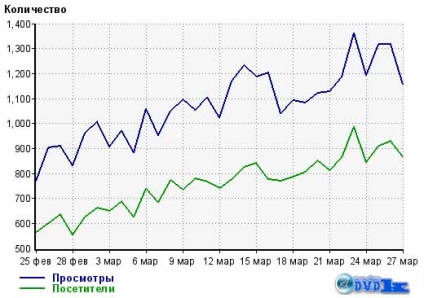

Сьогодні розповім, як я видалив Роботс з кореня свого блогу і підняв відвідуваність майже в два рази, завдяки цьому видалення. А точніше, я розповім, які правила robots необхідно прибрати, щоб трафік збільшився.

- Навіщо і які видаляти правила Роботс

- Як, це може вплинути на дублі сторінок

- Як видаливши правила robots.txt, збільшити відвідуваність

Заважають robots.txt правила або недоробка Google

Мені навіть прийшов лист щастя. Знаєте, що це таке? Цей лист від веб-майстра Google, яке приходить на EMAIL (електронний ящик), де сказано: ваш блог не оптимізований для мобільних пристроїв і в зв'язку з цим, він буде знижений в пошуковій видачі. Отримували такого листа?

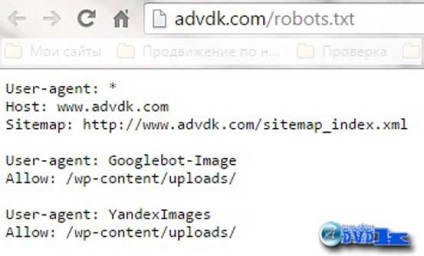

Мені відразу в голову прийшла ідея, а точніше згадав відмінність між шаблонами, ця відмінність було в правилах robots.txt. На моєму основному блозі були правила disallow, які забороняли доступ до деяких файлів, а на тестовому їх не було. Тут, я вирішив подивитися, прав я чи ні: видалив забороняють правила, і реально, блог став знову оптимізований.

Тут залишалося прийняти рішення: залишити все як є і «впасти в пошуку» або заробити дублі сторінок і теж «опуститися в пошуковій видачі». Рішення не просте, але все ж, я вирішив прибрати всі правила disallow, щоб подивитися на подальші зміни.

Справа в тому, що у мене в Роботс були закриті тільки технічні файли, типу wp-includes, wp-content і так далі. Рубрики, мітки і т.п. у мене були закриті відмінним правилом:

Навіть технічні файли не закриті. Як виявилося, вони нікому не потрібні! Може бути раніше, пошуковики забирали все, що «погано лежить», але зараз вони сильно порозумнішали, їм потрібні файли, тільки ті, які містять матеріал, необхідний користувачам інтернету.

А тепер про відвідуваність після видалення правил robots.txt

Як, я вже говорив: «не вдвічі, а майже», але все ж зросла. Результат видно, а це вже факти, в яких не можна поставити під сумнів, як в попередніх постах. Робіть зміни, але пам'ятайте про все, що я написав вище, не піддавайтеся небезпеки, якщо забули, то прочитайте статтю ще раз.

На цьому у мене все. Підписуйтесь на оновлення блогу. не пропускайте нові цікаві статті. Не бійтеся робити експерименти на блозі, адже в разі невдачі можна повернути все назад. До зустрічі!

Спеціально для Вас

Поділитися корисною інформацією

Я теж все практично відкрив в Роботс. ніякого сенсу закривати, дійсно, немає і ніякі дублі у мене не плодяться в зв'язку з таким відкриттям. треба просто правильно все налаштувати на блозі. я тільки не розумію одного - для чого в robots прописувати правила allow, адже все що не заборонено - те дозволено. моя думка - пошукачам ваще пофігу повинно бути на правило allow.

Я ці правила поставив, коли один блогер радив, це робити, але ніяких змін не помітив після їх додавання.

Давно кажу, що пора чистити Роботс, а мені мало хто вірить)

У мене стоїть заборона для wp-admin, тому що ця заборона є і в Роботс, який створює Вордпресс автоматично (якщо немає реального файлу і якщо Вордпресс встановлений в кореневу папку сайту). Все інше відкрито. Вже більше трьох місяців - політ нормальний.

Дублі звичайно на сайті тримати не варто, я свого часу теж позбулася їх, а ось що стосовно відвідуваності щось не зовсім розібралася, так як же ви її підвищили?

Швидше за все відкриттям пошуковим системам все потрібне для індексації і адаптивним дизайном.

Спасибі і вам за пораду 🙂

Привіт, Олексій. По-перше дякую за піар! 😉

Скрін статистики вражає.

Уявляєш, у мене виявляється теж блог не оптимізований для мобільних, незважаючи на те що варто плагін WPtouch Mobile. Тобто головна сторінка оптимізована, а внутрішні немає. Спочатку начебто все було ОК, в пошуковій видачі з'явився ярлик «Для мобільних». а потім прийшов лист щастя від гугл

Схожі статті