Напевно Вам вже відомо, що при внутрішній оптимізації сайту варто приділити особливу увагу індексації сайту, а саме факторам, які впливають на правильність індексації, адже якщо Ваш сайт буде некоректно індексуватися, то і на хороше ранжування сайту можете не сподіватися.

Іноді, ніби все зроблено і внутрішня оптимізація, і побудована грамотна стратегія просування, а сайт або не піднімається в пошуку, або вище 20-30 позиції не піднімається. Проблема може бути саме в коректності індексації сайту.

Як нам вже відомо, для правильності індексації необхідно:

- правильно поставити robots.txt;

- уникати дублів сторінок на сайті;

- не закривати контент від індексації;

- правильно вживати тег rel canonical;

- побудувати правильну пагінацію на сайті;

- уникати внутрішнього переспама;

- не допускати внутрішнього дубляжу як контенту, так і мета-даних;

- правильно розподіляти контрольний вагу.

Буває, ніби все пункти виконані, але часто в одному з цих пунктів, допускається помилка, а саме в файлі robots.txt.

На нашій практиці траплялося безліч проектів, які приходили до нас від інших фахівців. В результаті виявилося, що мало хто вміє правильно користуватися (це не камінь в чужий город, але таке трапляється часто механічно) правилами в robots.txt, хоча на перший погляд правила прописані правильно: закриті службові розділи, результати пошуку по сайту, сторінки з параметрами і т.д..

Але мова йде про те, як пошуковий робот бачить Ваш сайт, а саме, чи бачить він його також, як і користувач. Сторінка може індексуватися, а контент всередині неї може бути не видно роботу. Від сюди робиться логічний висновок, що робот не розумітиме, як і за яким контенту йому ранжувати сайт, якщо частина контенту не видно.

Щоб упевнитися в тому, правильно чи робот бачить Ваш сайт, можна скористатися інструментами Google: Mobile-friendly і Google webmaster.

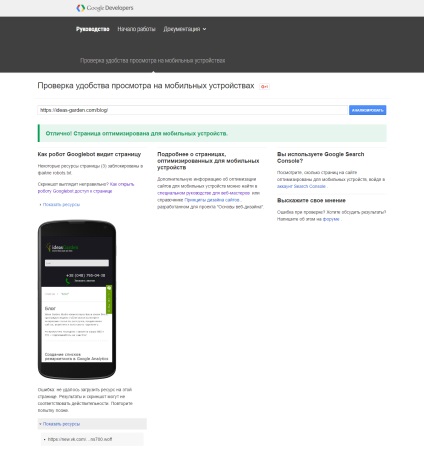

Перевірка за допомогою Mobile-friendly

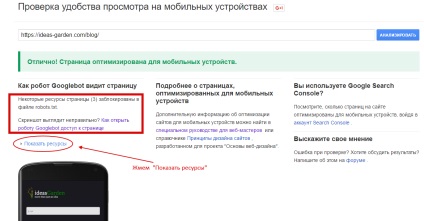

Бачимо, що деякі ресурси сторінки заблоковані. Для того, щоб подивитися, які саме, натискаємо на "Показати ресурси" і ми побачимо список ресурсів, які закриті в файлі robots.txt і яким необхідно відкрити доступ для пошукового робота.

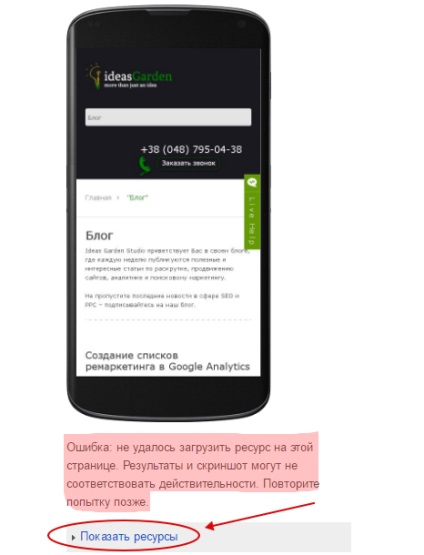

Тут Ви побачите список ресурсів, які не вдалося завантажити. Тобто, існують проблеми саме з їх завантаженням. Цю проблему також бажано усунути, оскільки зазначені ресурси можу то завантажуватися, то немає, що також буде погано позначатися на ранжуванні сайту. Якщо ж там знаходиться контент, який не спотворює суть самої сторінки, то такі ресурси можна не чіпати. Найчастіше, це зовнішні ресурси, на швидкість завантаження яких Ви, на жаль, ніяк не зможете вплинути.

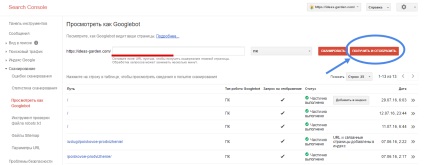

Перевірка за допомогою Search Console

За допомогою даного інструменту можна перевіряти як і мобільний, так і десктопних версії.

Отже, заходимо в Google webmaster і переходимо в розділ "Сканування" - "Подивитись як Googlebot". З'явиться наступне вікно

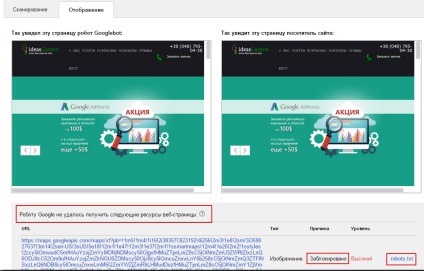

Після чого натискаємо кнопку ">>" що б подивитися, як робот бачить сайт в порівнянні з користувачем. Після натискання побачимо таке вікно:

справах висновки

Такі перевірки необхідно виконувати хоча б раз в 2 місяці, тому що в будь-який момент може виникнути проблема в доступності сайту і від цього ніхто не застрахований.