На сьогоднішній день пошукові системи - це один з найбільш простих і ефективних способів швидко знайти відповідь на питання, що цікавить, дізнатися останні новини або придбати товар, який дуже складно відшукати в торговій мережі. Але давайте подивимося на пошукову систему очима власників веб-ресурсів. Існують досить якісні і корисні сайти, до яких користувач просто не доходить через те, що вони і близько не потрапляють в ТОП-10 і навіть ТОП-50 пошукової видачі.

Часом і відмінно оптимізовані ресурси з прекрасним рейтингом і рівнем довіри пошукових систем можуть ранжуватися досить погано. Однією з основних причин цього є наявність великої кількості дублів і «непотрібних» (з точки зору пошукових систем) сторінок в індексі.

Основним і найбільш оптимальним інструментом для боротьби з дублями завжди був стандарт robots.txt. Основне його призначення - виключення з індексу небажаних сторінок, що дуже актуально для ефективного і результативного просування сайту в пошукових системах. Чи не станемо детально зупинятися на теоретичному описі призначення і синтаксису цього файлу. Про це можна прочитати на англомовному та російськомовному тематичних ресурсах. Ми ж докладно розглянемо практичну сторону застосування цього стандарту при просуванні в пошуковій системі Google.

- Заборона на індексування окремих сторінок, файлів і каталогів.

- Можливість налаштувати дозвіл на індексування окремих файлів в каталозі, який закритий від індексації (вказівка директиви «Allow» після відповідної директиви «Disallow»).

- Простота використання в порівнянні, наприклад, з мета-тегом (Його необхідно вказувати на кожній сторінці, яку потрібно закрити від індексації, в той час як файл robots.txt дозволяє закривати цілі каталоги).

- Можливість закриття всього сайту від індексації шляхом вказівки директиви «Disallow: /" (закриття тестової версії перед тим, як «викотити» оновлений сайт).

Попадання на другорядний індекс

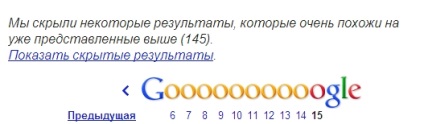

Сторінки, закриті від індексації, швидше за все, все одно потраплять в індекс Google. Зокрема, ці сторінки можна знайти в другорядному індексі пошуковика, зробивши запит за допомогою оператора «site: my-site .com» і натиснувши «Показати приховані результати».

Такі сторінки в індексі матимуть відповідне опис під посиланням на них:

Як відомо, наявність великої кількості сторінок в другорядному індексі - це і більш повільна індексація сайту з боку Google, і зниження позицій в результатах пошуку за рахунок того, що на сайті, на думку пошукача, є багато «непотрібних» для користувача сторінок, і т . п.

Некоректне прочитання файлу пошукачем

Ще одним істотним недоліком є те, що Google може некоректно прочитати інформацію в файлі robots.txt. Через це нормальні сторінки також можуть потрапити під другорядний індекс.

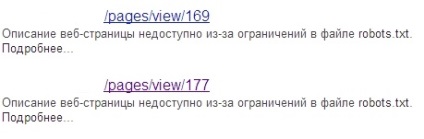

Наприклад, ось директиви, які вказані в файлі robots.txt сайту, А:

А ось ситуація, яка спостерігається в індексі Google при запиті за допомогою оператора «site»:

По перше. за допомогою оператора «site» завжди перевіряйте наявність потрібних сторінок в основному індексі. По-друге. використовуйте наступні способи для заборони індексації окремих сторінок.

- Вказуйте в блоці мета-тег

"] lt; meta name = laquo; robots raquo; content = laquo; noindex. nofollow raquo; gt;

"] lt; meta name = laquo; robots raquo; content = laquo; noindex. follow raquo; gt;

Недоліком даного способу є те, що сторінки, на яких прописаний цей мета-тег. не завжди закриті від індексації. Бувають випадки, коли вміст таких сторінок успішно індексується Google. В такому випадку «для підстраховки» можна вдатися до ще одного методу, який описаний нижче.

Це добре працює не тільки для повних дублів сторінки (наприклад, версії для друку), але і для часткових дублів. Наприклад, на сайті є кілька сторінок для одного і того ж товару, представленого в різних колірних варіантах. Оптимально при цьому буде вибрати одну з таких сторінок як основну (наприклад, товар в найбільш популярної забарвленням), а на інших сторінках в атрибуті вказати її як канонічну.

За допомогою цього інструменту можна видалити не тільки конкретну сторінку з індексу Google, але і всі сторінки в цьому каталозі, конкретні зображення або навіть весь сайт. Єдина порада: ретельно ознайомтеся з рекомендаціями Google щодо його використання.

- «Склеює» дублі за допомогою 301-го серверного редіректу

Останнім часом нові сторінки після 301-го редіректу потрапляють в індекс протягом 1-3 днів з моменту відправки запиту. Єдиний нюанс: краще не закривати від індексації старі сторінки, адже тоді пошуковий робот не зможе на них потрапити і «склеїти» з потрібною нам сторінкою.

- Використовуйте http-заголовок rel = «canonical»

Застосування цього способу буде оптимально для різних типів файлів з різноманітними розширеннями. pdf. xls і ін.

Підводячи підсумок, зазначу, що проблема боротьби з дублями завжди була і є актуальною для будь-якого SEO-фахівця. Тому не бійтеся експериментувати, використовувати різні варіанти боротьби з дублями, оцінювати результати і робити висновки, виходячи з практики, а не грунтуючись на голій теорії.

А є спосіб масово видалити з індексу Google сторінки заборонені в robots.txt (вони потрапили в додатковий індекс)? Прописав для них але вони вже більше місяця все одно триматися в індексі. Видаляти по одній вручну занадто довго. Віддавати для них 404-помилку якось ідеологічно неправильно. Є ще робочий спосіб?

Швидше за все після того як Ви прописали для цих сторінок робот Google до них ще не добрався і соответсвенно, він ще не знає, що вони закриті від індексації.

Якщо ж він їх проіндексував після того, як ви закрили їх за допомогою robots, але при цьому вони все одно в основному індексі, значить ви щось зробили не так.

Якщо таких сторінок не багато, спробуйте видалити їх вручну через GWT. Або налаштуйте на сайті 301 редирект на головну сторінку з усіх неіснуючих входжень.

301 на головну загрожує!

вручну, так це постійно видаляти треба (і не ефективно)!

Якщо у Вас є методи які дозволять вирішити описану вище проблему максимально ефективно, то поділіться ними з усім чесним народом :)

Не думаю, що зроблено щось не так. Більш ефективний спосіб - це прописати rel = canonical на тих сторінках, на нього гуглбот краще і швидше реагує ніж на мета-Роботс (головне, щоб після прописаний канонікала гуглбот ці сторінки побачив).

Владислав, з приводу того, що після закриття в Роботс сторінки все одно в індексі - так це вже стара практика. Невже, працюючи оптимізатором, не бачите видачу. Там навіть в ТОП по деяких запитах знаходяться сторінки, закриті в robots! І як по-вашому - це веб-майстер щось не так зробив. Або може, все таки, Google отжигает.

На жаль, від зростаючого кількості незрозумілих 404 і я страждаю :(

Вони з'являються незрозуміло де і благополучно індексуються, поки бачу один спосіб - перевіряти і виправляти вручну в GWT.

301 на головну з усіх неіснуючих. Владислав, прочитайте статтю, може трохи ясніше для Вас стане SEO-просування: