Всім привіт, друзі! Сьогодні я розповім, як створити файл robots txt для wordpress. Цей пост, буде дуже важливим для тих, у кого до цих пір немає файлу robots txt. Я постараюся розповісти вам основні команди, які використовуються в цьому файлі, щоб ви могли скласти самостійно robots txt а також покажу приклад, яким повинен бути правильний robots.txt для wordpress.

Але, найстрашніше те, що багато новачків навіть не підозрюють, що у них на блозі може бути дубльований контент. Після створення блогу, вони просто починають писати собі статті. Пишуть, пишуть, а тут раз, і сторінки вилітають з індексації. Потім вони думають, чому мій сайт потрапив під АГС. Я ж писав цікаві, унікальні статті для людей. Мій блог несе користь людям. Так, можливо це правда, і я це розумію, але пошуковий робот, на жаль, немає.

Перед тим, як я вам покажу, як створити файл robots txt для wordpress, давайте подумаємо, звідки взагалі можуть взятися дублі на сайті.

Це дві різні сторінки для пошукового робота, і останню, потрібно закривати від індексації. Як правильно це зробити, я поясню трошки пізніше.

Ну а взагалі, зараз я вам покажу правильний robots.txt для wordpress, який стоїть на моєму сайті. Ось приклад robots txt:

то потрібно просто прибрати з файлу robots.txt ось цей рядок

Disallow: / *? *. оскільки вона заблокує індексацію всіх сторінок, де зустрічається знак питання «?». Її потрібно прибрати в двох місцях.

Як скласти правильний robots.txt самому?

Якщо у вас інша система управління сайтом, то я вам зараз коротко розповім основні команди для того, щоб ви могли скласти robots.txt для свого сайту самостійно. Отже, поїхали.

Директива «User-agent» відповідає за те, до якого пошуковому роботу ви звертаєтеся.

- User-agent: * - до всіх пошукачам;

- User-agent: Yandex - тільки до Яндексу;

- User-agent: Googlebot - тільки до Гуглу;

Якщо ви хочете закрити весь сайт від індексації гуглом, то потрібно прописати так:

А якщо, навпаки, хочете, щоб весь сайт індексувався гуглом, то потрібно прописати в файлі robots.txt вод так:

Таким чином, ми можемо заборонити індексувати сайт або сторінку, Яндексу і гулу окремо, або всім пошуковим системам відразу.

Директива «Sitemap» дозволяє вказати карту сайту пошуковим роботам:

Є ще кілька директив, які розуміє тільки Яндекс.

Директива «Crawl-delay» дозволяє вказати затримку, з якої пошуковий робот буде відправляти вам команду. Якщо у вас великий сайт, то пошуковик постійним його вивченням може створити велике навантаження на сервер. І щоб цього не сталося, ви можете скористатися директивою «Crawl-delay»

Вод приклад:

Це означає, що інтервал між посилками команди буде 3 секунди. Але знову ж таки, це актуально тільки для Яндекса.

- Символ * - будь-яка, послідовність символів.

- Символ $ - кінець рядка.

Я зараз поясню, що це означає, і як ці символи використовувати при складанні файлу robots.txt

Спочатку розберемо, як використовувати «*». Наприклад, у мене є дубльована сторінка

Для того, щоб прибрати її з індексу потрібно прописати наступне:

Таким чином, я говорю пошуковому роботу: «Якщо в URL сторінки зустрінеш знак питання«? »То не індексуються її. І неважливо, які символи стоять до знака питання і після нього ».

Тому що перед знаком питання і після нього ми поставили зірочку «*». А вона, в свою чергу, означає будь-яку послідовність символів.

Ну а тепер розберемо, як використовувати символ $. Наприклад, у нас є вод така сторінка

і ми хочемо заборонити пошуковому роботу її індексувати.

Для цього потрібно прописати наступне

Таким чином, знаючи всього лише ці два спецсимволи, можна забороняти від індексації будь-яку сторінку або розділ сайту.

Як переконатися в тому, що ми склали правильний robots.txt?

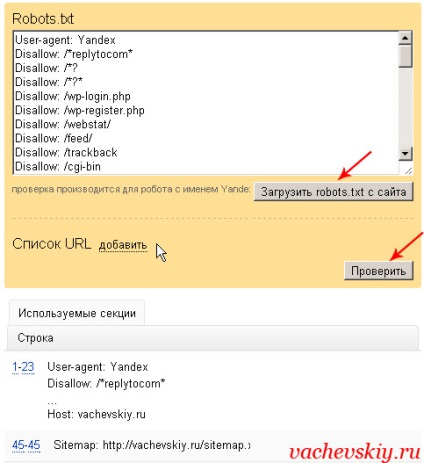

Для цього, перш за все, потрібно додати сайт в яндекс вебмайстер. Потім, потрібно зайти в розділ: «Налаштування індексування» - «Аналіз robots.txt».

Після цього потрібно завантажити файл robots.txt і натиснути на кнопку перевірити. Якщо ви побачите приблизно таке повідомлення, як на картинці, без помилок, значить у вас правильний robots.txt для wordpress або іншої системи управління.

Але ми ще можемо перевірити конкретну сторінку. Наприклад, я копіюю url статті, яка повинна бути відкрита для індексації, і перевіряю, чи так це насправді.

Ну вод і все, напевно, що стосується питання, як створити файл robots txt для wordpress. Та й не тільки для wordpress. Тепер ви повинні вміти скласти правильний robots.txt для будь-якої системи управління.