H (А) = log la = log16 = 4 [біт / символ]

Hmax (A) = log22 = 4,4594 [біт / символ]

2. Канальні матриці (КМІ, КМП, КМО) і їх взаємозв'язок

Канальна матриця визначає дію перешкод на дискретній каналі.

Канальні матриці бувають трьох видів: канальна матриця джерела, канальна матриця приймача і канальна матриця об'єднання.

Канальна матриця джерела (КМІ)

Канальна матриця джерела складається з умовних ймовірностей сигналів щодо переданих сигналів, які відображають дію перешкод на канал.

Ця матриця відображає статистичні характеристики дії перешкод. Канальна матриця джерела є матрицею прямих переходів переданих сигналів в прийняті сигнали.

Кожен рядок КМІ є розподіл умовних ймовірностей прийнятих сигналів щодо переданих сигналів. Всі ці умовні ймовірності p (bj / ai) і утворюють КМІ.

Канальна матриця приймача (КМП)

Дискретний канал повністю заданий, якщо відомі безумовні ймовірності прийому сигналів і задана канальна матриця приймача.

Умовні ймовірності р (ai / bj) прийому сигналів щодо переданих сигналів складають канальну матрицю приймача (КМП) і відображають дію перешкод на каналі.

Канальна матриця об'єднання (КМО)

Дискретний канал повністю заданий канальної матрицею об'єднання (КМО).

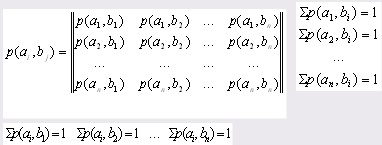

КМО складається з спільних ймовірностей появи сигналів і - р (ai, bj) і відображає дію перешкод на каналі зв'язку.

Елементами матриці є спільні ймовірності:

Взаємозв'язок канальних матриць

Властивості канальної матриці джерела (КМІ):

КМІ - квадратна матриця, тобто її розмір nxn;

Сума умовних ймовірностей кожного рядка дорівнює 1, тобто утворює повну групу:

Умовні ймовірності головної діагоналі КМІ відображають ймовірність правильного прийому сигналів щодо переданих сигналів;

Решта умовні ймовірності канальної матриці (крім головної діагоналі) відображають ймовірність помилкового прийому переданих сигналів;

Для ідеального каналу, на якому немає перешкод, канальна матриця має вигляд:

Властивості канальної матриці приймача (КМП):

КМП - це квадратна матриця, тобто її розмір nxn;

Сума умовних ймовірностей кожного стовпчика дорівнює 1, тобто утворює повну групу:

Умовні ймовірності головної діагоналі КМП відображають ймовірність правильного прийому сигналів щодо переданих сигналів;

Решта умовні ймовірності канальної матриці приймача (крім головної діагоналі) відображають ймовірність помилкового прийому переданих сигналів;

Для ідеального каналу, на якому немає перешкод, КМП має вигляд:

Властивості канальної матриці об'єднання (КМО):

Сума спільних ймовірностей кожного рядка дорівнює безумовній ймовірності джерела:

дискретний матриця приймач кодування

Сума спільних ймовірностей кожного стовпчика дорівнює відповідній безумовної ймовірності приймача:

Сума всіх елементів канальної матриці об'єднання дорівнює 1.

3. Інформаційні характеристики джерела повідомлень

Для того, щоб зрозуміти що таке інформаційні характеристики, потрібно спочатку дати визначення таким термінам, як алфавіт повідомлення, кортеж упорядкованих унікальних символів і дискретний ансамбль повідомлення (ДАС).

Алфавітом повідомлення називаються символи, які входять в повідомлення. наприклад:

Кортеж упорядкованих унікальних символів - це впорядкована послідовність символів.

Х = - повідомлення - кортеж символів

Дискретний ансамбль повідомлення (ДАС) - повідомлення з вірогідністю символів ДАС

3.1 Кількість інформацією джерела повідомлень

Кількістю інформації символу повідомлення визначається:

I (ai) = - log2 (p (ai)) = - log (p (ai)) [біт] (i = 1,2 ... n)

У Шенноновская теорії інформації кількість інформації джерела визначається ймовірністю появи символу.

I (ai) = - ln (p (ai)) [нат]

I (ai) = - lg (p (ai)) [дит]

Кожен символ повідомлення містить своє кількість інформації.

Властивості кількості інформації джерела повідомлень

1. Кількість інформації неотрицательно:

2. Чим вище ймовірність, тим менша кількість інформації містить символ.

3. Якщо ймовірність символу дорівнює 1, то кількість інформації цього символу дорівнює 0.

р (ai) = 1 → I (ai) = 0

4. Адитивність. Кількість інформації декількох символів дорівнює сумі кількостей інформацій кожного.

I (a1, a2, a3) = I (a1) + I (a2) + I (a3)

Ентропія - середня кількість інформації на символ повідомлення (за шкалою А).

1. Ентропія неотрицательна: Н (А) ≥ 0

2. Ентропія дорівнює нулю тоді і тільки тоді, коли ймовірність символу дорівнює 1: Н (ai) = 0 ↔ р (ai) = 1

3. Ентропія обмежена: H (ai) ≤ log n [біт / символ]

де n - кількість символів в повідомленні.

4. Максимальна ентропія дорівнює: Hmax (А) = log n [біт / символ]

3.2 Інформаційні втрати

Існує два види умовної ентропії, які визначають дії перешкод на дискретній каналі - це приватна умовна ентропія (ЧУЕ) і загальна умовна ентропія (ОУЕ).

Приватна умовна ентропія джерела (ЧУЕІ) повідомлень відображає кількість втрат інформації при передачі кожного сигналу аi:

H (В / а i) = - p (bj / ai) log p (bj / ai) (i = 1,2 ... n) [біт / символ]

Загальна умовна ентропія джерела (ОУЕІ) визначає середні втрати кількості інформації на прийнятий сигнал щодо переданих сигналів.

4. Інформаційні характеристики приймача повідомлень

4.1 Кількість інформації приймача

Кількістю інформації символу повідомлення визначається:

I (bj) = - log2 (p (bj)) = - log (p (bj)) [біт] (j = 1,2 ... n)

У Шенноновская теорії інформації кількість інформації приймача визначається ймовірністю появи символу.

I (bj) = - ln (p (bj)) [нат]

I (bj) = - lg (p (bj)) [дит]

Кожен символ повідомлення містить своє кількість інформації.

Властивості кількості інформації приймача повідомлень

1. Кількість інформації неотрицательно: I (bj) ≥ 0

2. Чим вище ймовірність, тим менша кількість інформації містить символ.

3. Якщо ймовірність символу дорівнює 1, то кількість інформації цього символу дорівнює 0.

р (bj) = 1 → I (bj) = 0

4. Адитивність. Кількість інформації декількох символів дорівнює сумі кількостей інформацій кожного.

I (b1, b2, b3) = I (b1) + I (b2) + I (b3)

Ентропія - середня кількість інформації на символ повідомлення (за шкалою А).

1. Ентропія неотрицательна:

2. Ентропія дорівнює нулю тоді і тільки тоді, коли ймовірність символу дорівнює 1:

Н (ai) = 0 ↔ р (ai) = 1

3. Ентропія обмежена

H (B) = де n - кількість символів в повідомленні. 4. Максимальна ентропія дорівнює Hmax (B) = log n [біт / символ] 4.2 Інформаційні втрати Існує два види умовної ентропії, які визначають дії перешкод на дискретній каналі - це приватна умовна ентропія (ЧУЕ) і загальна умовна ентропія (ОУЕ). Приватна умовна ентропія приймача (ЧУЕП) повідомлень визначає втрати інформації кожного прийнятого сигналу. H (A / bj) = - p (ai / bj) log p (ai / bj) (j = 1,2 ... n) [біт / символ] Загальна умовна ентропія приймача (ОУЕП) визначає середні втрати інформації на символ при прийомі ансамблю: 5. Швидкісні характеристики 5.1 Швидкість модуляції [симв / сек] де - тривалість передачі одного сигналу Якщо тривалість передачі сигналів різна, то обчислюється середній час передачі одного сигналу. 5.2 Продуктивність джерела бод; Продуктивність джерела - кількість біт, що виробляються в одиницю часу - 1 секунду. 5.3 Швидкість передачі або бод; Швидкість передачі джерела: Швидкість передачі приймача: 5.4 Ємність каналу або бод; Ємність каналу (пропускна здатність каналу) - це максимальне кількість біт, що передається в одиницю часу - секунду. Пропускна здатність - максимальна швидкість передачі. Ємність каналу джерела: Ємність каналу приймача: 5.5 Коефіцієнт ефективності дискретного каналу Чим більше коефіцієнт ефективності дискретного каналу наближається до одиниці, тим ефективніше канал і тим менше інформаційні втрати на ньому. 5.6 Теореми Шеннона про критичної швидкості і кодуванні Теорема про критичну швидкості: Теорема визначає критичну швидкість передачі, що залежить тільки від розподілу ймовірності, при якій існує спосіб передачі зі швидкістю R (), при якому можливе відновлення вихідного повідомлення (), де С - пропускна здатність каналу, Н (А) - ентропія джерела; Теорема про кодування: Якщо H '(A) - продуктивність джерела - менше ємності каналу (), то існує спосіб кодування і декодування, при якому ймовірність помилки буде як завгодно мала і навпаки. Приклад розрахунку швидкісних характеристик для канальної матриці джерела. 1. Вихідні дані Дана матриця умовних ймовірностей, які відображають дію перешкод дискретного каналу зв'язку. Сума ймовірностей кожного рядка дорівнює 1,00. Час передачі символу τ = 0,0002 сек. Передано 250 символів. Безумовні ймовірності появи символів на виході: p (a1) = 0.25, p (a2) = 0.35, p (a3) = 0.15, p (a4) = 0.25 1) Кількість інформації I (ai) кожного символу a1, a2, a3 дискретного повідомлення: 2) Середня кількість інформації, передане одним символом визначає ентропія джерела повідомлень Н (А): H (A) = - (0,25 * (- 2) + 0,35 * (- 1,51) + 0,15 * (- 2,73) + 0,25 * (- 2) = - (- 0,5 - 0,53 - 0,41 - 0,5) = 1,94 [біт / символ] 3) Максимальна ентропія джерела повідомлень Hmax (A) Hmax (A) = log N = log 4 = 2 [біт / символ] де N-кількість символів в алфавіті повідомлення. 4) Інформаційні втрати при передачі кожного символу ai визначає приватна умовна ентропія H (B / ai): -(-0,1368 - 0,2161 - 0,1518 - 0,1129) = 0,6175 [біт / символ] -(-0,3321 - 0,2112 - 0,2435 - 0) = 0,787 [біт / символ] -(-0 - 0,0664 - 0,0286 - 0,0664) = 0,1614 [біт / символ] H (B / a4) = - (0 + 0 + 0,01 * (- 6,64) +0,99 * (- 0,0145)) = -(-0- 0 - 0,0664 - 0,0144) = 0,081 [біт / символ] 5) Середні втрати інформації при передачі одного Інформаційним називають процес, що виникає в результаті встановлення зв'язку між двома об'єктами матеріального світу: джерелом. або генератором інформації та її приймачем, або одержувачем. Теорія інформації як наука, предмет і методи її вивчення, застосування в комп'ютерній техніці. Системи передачі інформації, різновиди повідомлень і їх джерела. Різновиди перешкоди і способи їх усунення. Апаратура, яка використовується при передачі даних. Основні поняття і визначення кодування інформації. Кодова комбінація і її довжина. Класифікація кодів за різними ознаками, способи їх подання, призначення. Подання у вигляді кодових дерев або многочленів, матричне і геометричне. Біт, невизначеність, кількість інформації та ентропія. Формула Шеннона. Формула Хартлі. Логарифми. Кількість інформації, що отримується в процесі повідомлення. Взаємодія джерела і приймача інформації. Кількість, інформаційна ємність осередків пам'яті. Основи теорії передачі інформації. Експериментальне вивчення кількісних аспектів інформації. Кількість інформації по Хартлі і К. Шеннон. Частотні характеристики текстових повідомлень. Кількість інформації як міра знятої невизначеності. Оптимальне статистичне (економне) кодування. Основні поняття і визначення теорії кодування. Принципи побудови оптимальних кодів. Здатність системи здійснювати прийом інформації в умовах наявності перешкод. Збільшення потужності сигналів. Посібник для студентів та викладачів. Механізм передачі інформації, її кількість і критерії вимірювання. Одиниці інформації в залежності від підстави логарифма. Основні властивості і характеристики кількості інформації, її ентропія. Визначення ентропії, надмірності інформаційних повідомлень. Джерело (передавач) і одержувач (приймач) служать для обміну деякої інформацією. В одному випадку відправником і одержувачем інформації служить Програма розрахунку інформаційних характеристик каналу зв'язку. Побудова коду для передачі Повідомлень. Процедури кодування, декодування та оцінка ефектівності кодів. Програма на алгорітмічній мові Паскаль. Канальна матриця, что візначає Втрата информации. Особливості обчислення кількості інформації, одержуваної при фазовому зсуві сигналу, якщо відома його амплітуда. Розрахунок інформаційних характеристик джерел дискретних повідомлень і дискретного каналу. Особливості застосування дискретизації і квантування. Загальна схема дії каналів зв'язку, їх класифікація та характеристика. Дискретний, бінарний канал зв'язку і визначення їх пропускної спроможності, особливості дії з перешкодами і без них по теоремі Шеннона. Пропускна здатність безперервного каналу. 2.2.2. Інформаційний критерій оцінки фонетичної неопреде-лінощів. При розпізнаванні усного мовлення необхідно прагнути до того, щоб всі фонеми класифікувалися правильно, тому нас цікавить розпізнавання повної послідовності фонетичних одиниць, складових висловлювання. Загальна кількість неповторюваних повідомлень. Обчислення швидкості передачі інформації та пропускної здатності каналів зв'язку. Визначення надмірності повідомлень і оптимальне кодування. Процедура побудови оптимального коду за методикою Шеннона-Фано. Sub це те ж саме, що і Function, тільки вона не повертає значення, а виробляє яку-небудь дію. Наприклад Вибір нотатки або маніпулювання декількома властивостями. Генерація породжує полінома для циклічного коду. Перетворення породжує матриці в перевірочну і назад. Розрахунок кодового відстані для лінійного блокового коду. Генерація таблиці залежності векторів помилок від синдрому для двійкових кодів. Обробку великих обсягів інформації за допомогою комп'ютера не можна ефективно організувати тільки шляхом вдосконалення технічних засобів - збільшуючи обсяги пам'яті, скорочуючи час звернення до зовнішніх носіїв і т.д. Рішення типових задач з телекомунікацій. Аналіз ймовірності входу в систему зловмисником з одного і трьох спроб. Ймовірності входу в систему при фіксованій та випадкової довжині вибірки. Дослідження і розрахунок захищеності (надійності) методу при підглядання. Оптимізація довжини вибірки. Об'єднання як сукупність кількох ансамблів дискретних, випадкових подій. Безумовна ентропія - середня кількість інформації, що припадає на один символ. Опис інформаційних властивостей безперервного джерела. Поняття диференціальної ентропії.Схожі статті