З тих пір, як створення сайтів стало масовим виробництвом, якість їх помітно впала. І справа не у видимій частині - тут якраз все красиво і чудово. Безлад діється всередині. І якщо від користувачів це ще можна приховати, то від програм - немає.

Чому вам варто турбуватися про якісь програмах? Тому що саме від них залежить, чи побачать користувачі ваш ресурс чи ні. В першу чергу - це браузери і пошукові роботи. Їх не цікавить естетика сайту - вони читають код, і його гармонійність впливає на кінцевий результат їх роботи: відображення сторінок або індексація вмісту.

Подивіться на свій ресурс очима роботів. Для цього не потрібно володіти спеціальною технічною підготовкою - винайдено велику кількість сервісів, які дозволяють виконати діагностику за лічені хвилини. Навіть цього базису буде досить, щоб знайти критичні помилки.

1. Перевантажений код

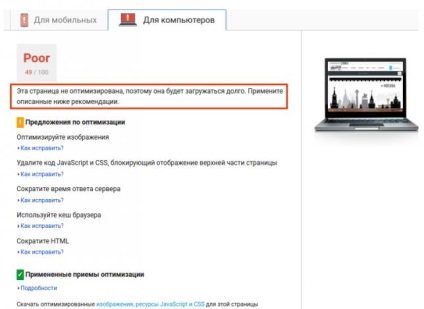

Розплатою за ефектний і красивий сайт може стати зниження швидкості завантаження сторінок. Причина цього - велика кількість незначних байтів в файлах HTML, CSS і скриптів, великий обсяг ресурсів (картинки, стилі, тексти), скрипти, що завантажуються вперед основного контенту (лічильники, лайтбокси, віджети). Інша часто зустрічається помилка - відключене кешування в браузері.

Приклад: сайт інтернет-магазину «Надійно» зовні красивий, але обтяжений прихованими проблемами. Швидкість промальовування основного контенту може серйозно знижуватися при певних умовах (наприклад, при слабкому сигналі мобільного інтернету).

2. Дублі сторінок

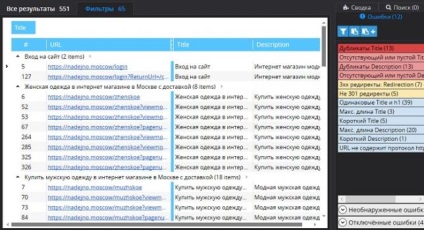

Дублі - це сміття, яке засмічує структуру сайту і ускладнює індексацію контенту пошуковими роботами. Вони вкрай небажані для пошукового просування, так як сильно розмивають картинку релевантності цільових сторінок. Найпростіше знайти таке сміття в порівнянні тегів заголовків сторінок Title і мета Description. Збіг цих даних буде вказувати на ознаки дублів.

спосіб 1: десктопна програма Netpeak Spider (від $ 10 в місяць, 14 днів безкоштовний тестовий період). Вказуєте URL сайту, задаєте фільтри (відобразити результати по Title і Description) і перевірка протікає автоматично.

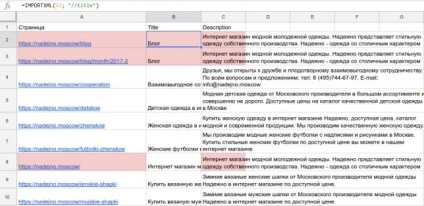

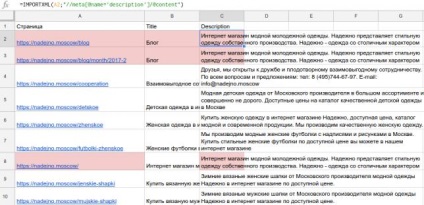

спосіб 2: таблиця Google Docs (безкоштовно).

Створюєте таблицю, вносите в неї сторінки вашого сайту, прописуєте формули для парсинга і протягуєте осередки. Далі можна зробити сортування за алфавітом і ви відразу побачите ідентичні теги Title і / або мета Description.

Приклад: перевірка сайту магазину за допомогою Google Docs показала наявність часткових дублів.

а) перевірка Title

б) перевірка Description

Як мінімум, слід переписати вміст цих елементів і подивитися, чи не ідентичний чи основний контент даних сторінок.

3. Надлишок ключових слів в текстах

Хоча тексти не приховані під пологом сайту, розгледіти їх якість не завжди можливо. Особливо, якщо на вашому ресурсі не десять, а десять тисяч сторінок. Машина за дві секунди визначить, унікальні вони чи ні, чи є Переспа ключовими словами чи ні. І щоб не зіграти в «Баден-Баден», необхідно випередити пошукових роботів - перевірити контент і усунути недоліки.

на унікальність - онлайн-сервіс content-watch.ru (безкоштовно);

на заспамленності - онлайн-сервіс text.ru (безкоштовно).

Приклад: перевірка опису до розділу каталогу «Чоловіче» показала 100% унікальності тексту.

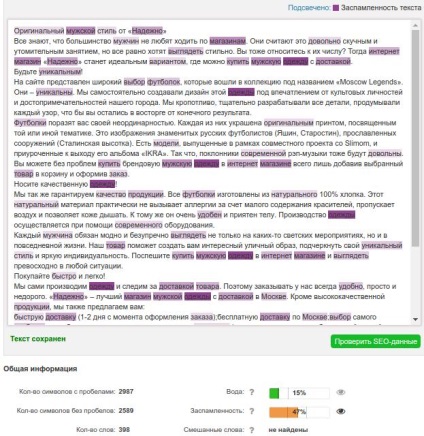

А ось перевірку на рівень оптимізації цей же текст пройшов з незадовільним результатом: занадто багато повторів ключових слів.

Це лише вершина айсберга

Прихованих помилок на сайті набагато більше, ніж ми привели в статті. Це чергове нагадування власникам ресурсів і маркетологам не залишати без уваги таку важливу процедуру як аудит сайту. Самостійна перевірка посильна для невеликих сайтів. Величезних ресурсів на тисячі і десятки тисяч сторінок буде потрібна допомога фахівця, який щодня вирішує подібні завдання і має серйозний набором інструментів діагностики.

Не полінуйтеся, перевірте ваш сайт і приступите до роботи над помилками. А якщо потрібна допомога - наш «Персональний менеджер» до ваших послуг.