І, що ще важливіше, ця надзвичайно корисна програма вимагає особливої уваги до етичних аспектів, так що доречно ще раз повторити моральні вказівки, які команда творців WebHTtrack постійно підкреслює.

Не потрібно робити щось тільки тому, що ти можеш це зробити ... *

Ніхто краще вас не простежить за чистотою ваших моральних засад, тому:

Чи не крадіть закриту приватну інформацію

Не завантажуйте закриту інформацію

Чи маєте ви право скопіювати сайт для особистих цілей?

Не робіть копії сайту доступними в інтернеті, за винятком випадку, якщо це прямо дозволено власником цього сайту.

Нарешті, ця програма - не інструмент для організації атак на відмову в обслуговуванні або інших шкідливих акцій;

Не перевантажуйте сайти, які ви копіюєте (до питання про вже згаданих моральних аспектах); скачування сайту може перевантажити його підключення до інтернету, особливо якщо ви завантажуєте занадто багато динамічно генеруються сторінок. З іншого боку, майте на увазі завантаження свого каналу зв'язку і необхідне місце на жорсткому диску! Тому:

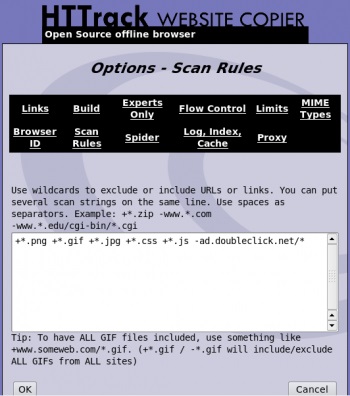

Не завантажуйте великі сайти цілком, використовуйте фільтри

Не дозволяйте програмі відкривати занадто багато з'єднань одночасно

Задавайте в налаштуваннях програми обмеження: обмежте швидкість скачування, число одночасних з'єднань, встановіть ліміти на розміри і на час

Вимикайте обробку файлів robots.txt тільки в крайньому випадку

По можливості не завантажуйте сайти в робочий час

Перевірте обмеження на швидкість скачування і розмір при регулярному оновленні своїх копій

Перш ніж робити великі копії, спочатку запитайте дозволу у адміністратора сайту (звичайно, якщо це не ви самі)!