- Відключений енергозберігаючий режим

- Часовий пояс GMT + 4

- Встановлені всі оновлення через WSUS

Чотири мережеві картки по дві на кожну систему.

Login: ekzorchik (Обліковий запис складається в групі - Domain Admins)

Eth0: 10.0.2.19 - зовнішня мережа для домену polygon.local

Subnet Mask: 255.255.255.0

Eth1: 192.168.117.2 - внутрішня мережа, тобто cluster 1 дивиться на cluster 2 і нікуди більше.

Шлюзу і DNS немає.

Eth0: 10.0.2.21 - зовнішня мережа для домену polygon.local

Subnet Mask: 255.255.255.0

Eth1: 192.168.117.3 - внутрішня мережа, тобто cluster 2 дивиться на cluster 1 і нікуди більше

Subnet Mask: 255.255.255.0

Шлюзу і DNS немає.

Підготуємо хости Cluster1 і Cluster2 встановивши, в них компонент «FailoverClustering».

Налаштування на хостеCluster1

Запускаємо оснащення для додавання компонента «Засіб відмовостійкості кластерів»

Компонент «Failover Clustering»

Проходимо через Next і Install і чекаємо, поки компонент встановиться.

Налаштування на хостеCluster2

Проробляємо такі ж маніпуляції, як і з хостом Cluster2 по установці компонента.

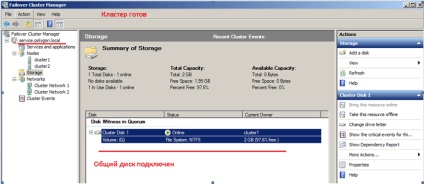

Тепер підключимо загальний диск для обох хостів.

Щоб заробив кластер нам потрібен загальний диск підключений до наших систем Cluster1 і Cluster2 для цього задіємо вбудовану оснащення «iSCSIInitiator». Як налаштувати підключення я вже розписував, робимо згідно з інструкцією.

Після переходимо на систему Cluster1. далі відкриваємо оснащення «Start» - «ControlPanel» - «AdministrativeTools» - «Server Manager» - «Storage» - «Disk Management» (Управління дискової системою)

І звертаємо увагу, що у нас з'явився підключений через оснащення "iSCSIInitiator» диск:

Зараз потрібно його перевести в «Online» режим:

Створюємо тому (New Simple Volume ...):

вказуємо розмір тому в мегабайтах (я залишу за замовчуванням 2045), і дамо букву для логічного диска, наприклад «Q». вкажемо файлову систему (NTFS) і мітку тому (наприклад «Quorum»).

Далі потрібно зайти на другий вузол Cluster2. також відкрити оснастку «Start» - «ControlPanel» - «Administrative Tools» - «Server Manager» - «Storage» - «Disk Management» (Управління дискової системою) і за таким же принципом, як вище активуємо диск, розмічаємо, але після переводимо в стан «Offline».

Підготовча частина закінчена.

Тепер можна перейти до об'єднання вузлів Cluster1 і Cluster2 в кластер.

Дану процедуру виконуємо тільки один раз

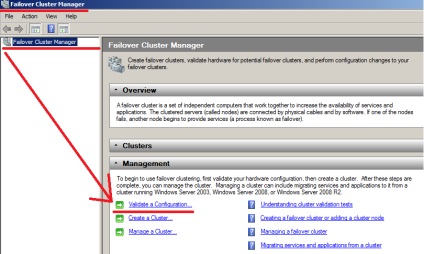

Для цього зайдемо на перший хост Cluster1 і відкриваємо оснащення «Failover Cluster Manager» для конфігурації.

У що з'явилася оснащення слід запустити майстер перевірки конфігурації - «Validatea Configuration ...»

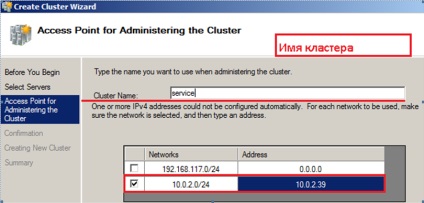

Зараз, коли на обох хостах встановлений компонент, можна перейти до створення кластера.

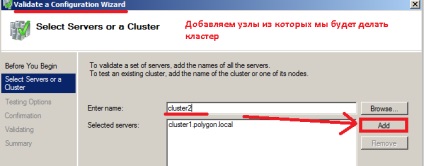

Зараз необхідно вибрати вузли, з яких будемо робити кластер. на предмет відповідності вимогам.

Вводимо ім'я сервера, в моєму випадку Сluster1 і натискаємо Add (Додати).

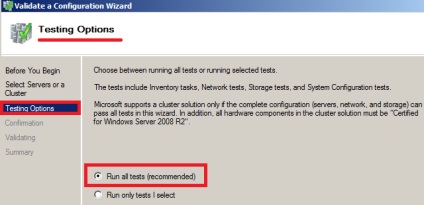

Натискаємо знову Next і на наступному кроці відзначаємо пункт - «Run All Tests (recommended)» (Провести всі тести).

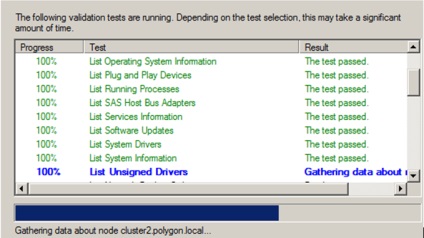

На представленому скріншоті нижче видно, що тести завершуються успішно і Ви можете помічати, то поява, то зникнення нашого підключеного загального iSCSI диска.

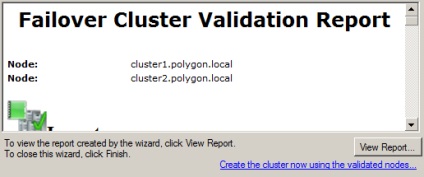

Після закінчення тестів можна ознайомитися зі звітом в якому присутні проблемні місця, що заважають при піднятті кластера:

У моєму випадку все добре, проблем немає.

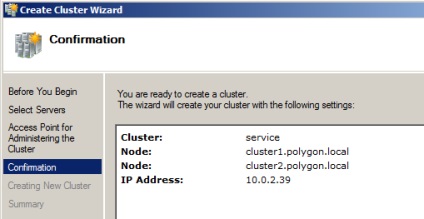

На цьому всі підготовчі кроки завершені, натискаємо Next. власне і відбувається установка. Після закінчення розгорнувши оснащення «Failover Cluster Manager» бачимо ім'я кластера, Ноди з яких він складається і загальний диск.

Ось власне і весь процес підняття кластера в тестових умовах. Дана замітка своєрідний покроковий процес конфігурації і тестування функціоналу для застосування вже в бойовій системі. На цьому все, удачі.