На сайті кожного хорошого інтернет-магазину є блок з фільтрацією, за допомогою якого користувачі можуть швидко знайти необхідний їх товар. Цей функціонал - обов'язковий атрибут інтернет-магазину.

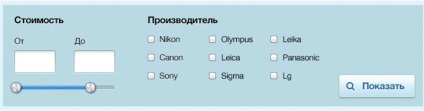

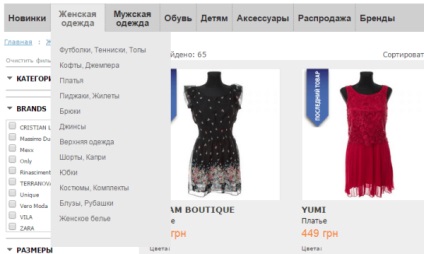

Типовий приклад фільтрів на інтернет-магазині:

Але фільтри також можуть завдати істотної шкоди ранжирування та індексації сайту в пошукових системах. На жаль, власники бізнесу про це не замислюються на етапі створення інтернет-магазину, а варто було б, так як впровадження мінімального SEO-friendly позбавить сайт від технічних проблем з індексацією і ранжування ресурсу в пошукових системах.

Розберемося які проблеми для ранжирування несуть в собі найбільш поширені методи фільтрації.

1. Система фільтрації на Ajax:

Це, швидше за все, система фільтрації на CMS Opencart, теж Ajax. Все сторінки з хештегом # не індексуються. тому розглянемо ці види разом.

Звідси випливає, що ніяких дублів бути не може і пошукова система не витрачає краулінговий бюджет на сканування та індексацію непотрібних сторінок за результатами фільтрації виду:

Жіночі сукні / Сині / 44размера / Mexx / ціна від 100 до 500 грн / Розпродаж

Очевидно, що на таку сторінки не буде трафіку, так як це не обумовлено попитом. Немає сенсу створювати сотні тисяч таких сторінок, це не дасть ніякого результату, тільки завантажить робота роботою по скануванню мільйонів таких сторінок.

Але є і проблема: куди повинні вести запити виду:

- Жіночі сукні Mexx,

- Жіночі сукні з льону,

- Жіночі сукні з Білорусії.

Для таких запитів немає релевантних сторінок, трафік за такими запитами сайт не отримає, а це вже проблема. Сайт втрачає безліч трафіку через відсутність релевантних сторінок для товарні груп, які обумовлені попитом.

Плюси: Немає дублікатів, немає проблем з індексацією.

Варіанти вирішення проблеми:

В даному випадку нам не потрібно вирішувати проблеми з індексацією, дублями і сміттєвими сторінками, тому тут рекомендацій буде не так багато.

- За ціною,

- Від А до Я,

- За кількістю товарів на сторінці,

- За популярністю,

- За назвою,

- нові,

- Акційні.

Кількість таких фільтрів може бути дуже великим, що, в свою чергу, породжує безліч однакових за своїм змістом і призначенням сторінок.

Виходить, ось така картина:

- Завантажено роботом - 860 148.

- Сторінок в пошуку - 116 946.

- Корисних і унікальних сторінок на сайті

Виходить наступна ситуація - пошукові системи скачали з сайту майже мільйон сторінок, а корисних, з точки зору пошукових систем, всього 0,5%.

Мінуси: безліч дублів і сміттєвих сторінок, проблеми з індексацією, сайт низько ранжируется.

Рішення проблеми:

Даний вид фільтрації набагато складніше оптимізувати, так як варіантів вирішення проблеми дуже багато.

В першу чергу нам необхідно визначитися з цілями, а саме:

- Не допустити потрапляння в індекс пошукових систем сторінок, які не містять ніякої корисної інформації.

- Забезпечити максимальне охоплення цільової аудиторії.

- Не допустити сканування сміттєвих дублюються сторінок. Розумно використовувати краулінговий бюджет.

Необхідно виділити загальні параметри для фільтрів, за якими ми зможемо закрити дані сторінки від індексації за допомогою файлу Robots.txt.

Приклади параметрів, за якими потрібно визначити сторінки і закрити їх від індексації:

Візьмемо все той же сайт Lamoda.ua. навскидку я знайшов там такі параметри:

Це, звичайно ж, не всі параметри, які потрібно закрити від індексації.

Тобто ми вибираємо всі сміттєві і непотрібні сторінки (які не принесуть нам трафіку) і закриваємо їх від сканування.

Тепер спробуємо збільшити охоплення цільової аудиторії за допомогою оптимізації сторінок фільтрів, які можуть приносити трафік (бренд, матеріал).

Таким от нехитрим чином можна істотно розширити охоплення цільової аудиторії і привернути додатково багато трафіку з пошукових систем.

На закінчення

При створенні / просуванні інтернет-магазину важливо правильно оптимізувати систему фільтрації, щоб сайт ранжирувався відповідно до своєї релевантність.

Якщо ви знайшли помилку, виділіть фрагмент тексту і натисніть Ctrl + Enter або скористайтеся посиланням. щоб повідомити нам.

спасибі за докладний опис. у мене є питання:

1. яким чином закривати get параметри від індексації, якщо не через robots.txt?

2. як розподіляти по сторінках фільтрів пересічні ключові фрази, наприклад,

«Кутова меблі для вітальні на замовлення класика»

«Кутова меблі для вітальні»

«Вітальні класика»,

якщо розділ «вітальні» містить фільтри: «кутові», «класичні» і т.д.

як уникнути «канібалізації» ключових слів?

3. як складаєте матрицю сайту, щоб зрозуміти які фільтри будуть в кожному розділі? вручну або використовуєте сервіси?

Добрий день, велике спасибі за запитання.

1. Можна за допомогою мета тегу robots = "noindex, follow».

2. Я б розподілив запити таким чином:

Кутова меблі для вітальні:

«Кутова меблі для вітальні на замовлення класика»

«Кутова меблі для вітальні»

Вітальні в класичному стилі:

«Вітальні класика»

Не потрібно доробити структуру занадто дрібно, щоб під кожен потенційний запит була окрема сторінка - це шлях під фільтр. Тут головне не перестаратися.

Під запит «кутова меблі для вітальні на замовлення класика» я не рекомендую робити окрему сторінку, в рази простіше буде на сторінці «кутова меблі для вітальні» додати входження ключових слів «на замовлення» «класика» і запит буде в топі.

Я не прихильник створювати комбінації з фільтрів, з ними завжди дуже багато проблем, як з визначенням релевантної сторінки, так і з розподілом веса.Стоіт морочитися тільки якщо є великий попит, а не один запит з частотністю 10.

3. Що таке матриця сайту?) При зборі семантики відразу видно під які групи запитів потрібно створювати сторінки.

Мені так зручно, і не виникає ніяких проблем з візуалізацією в голові структури сайту. Тому не використовую ніяких сервісів для роботи із зібраною семантикою. Не було необхідності в цьому.

зрозуміла Вас, спасибі за відповідь.