Експерти хочуть зрозуміти, як навчити самоврядні автомобілі приймати правильні рішення з точки зору моралі.

Уявіть, що у вашого автомобіля відмовили гальма. І перед вами постає вибір: збити переходять дорогу п'ятьох людей похилого віку або згорнути в сторону, задавив жінку з коляскою. А що в такій ситуації повинен зробити безпілотний автомобіль, задалися питанням в Массачусетському технологічному інституті США. Вчені вирішили з'ясувати, як безпілотні автомобілі повинні вирішувати питання про життя і смерті, не йдучи врозріз із суспільною мораллю.

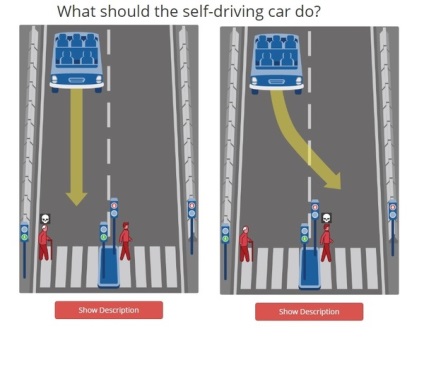

Наприклад, в одній із ситуацій необхідно вирішити, хто з двох пішоходів залишиться в живих. Дорогу переходять одночасно молодий і літній чоловік. У кого з них повинен поїхати самоврядний автомобіль, що втратив контроль?

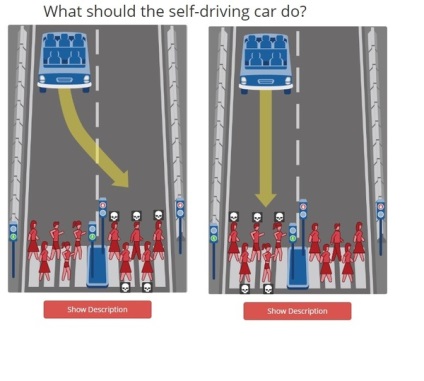

Інший слайд моделюють ситуацію, коли дві групи пішоходів переходять дорогу на червоне і зелене світло. У цьому випадку питання встає, кого залишити в живих переходять на червоний або зелений сигнал світлофора.

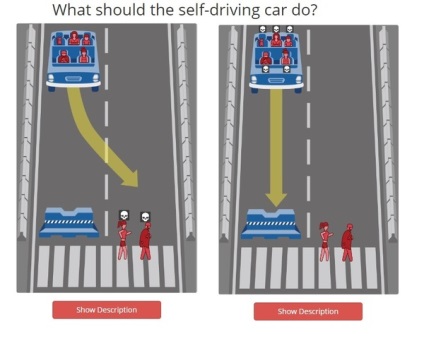

Крім того, користувачам пропонують вибрати між життями тварини і людини. Також моделюються ситуації, коли користувач повинен зробити вибір між життям водія і пішохода. В кінці тесту користувач може побачити результати, що показують, кого частіше він вважав за краще залишити в живих і навпаки.

На сьогоднішній день Moral Machine зібрала вже понад 11 млн можливих сценаріїв з відповідей користувачів. Розробники тесту вважають, що їх напрацювання допоможуть досягти рівноваги законодавства, морального комфорту і громадської безпеки в питанні використання безпілотних транспортних засобів.