Навіщо це Google?

У даній статті на прикладі сайту bsodstop.ru покажу, як задовольнити пошукового робота. Тим більше, що мій метод відрізняється від запропонованих іншими блогерами.

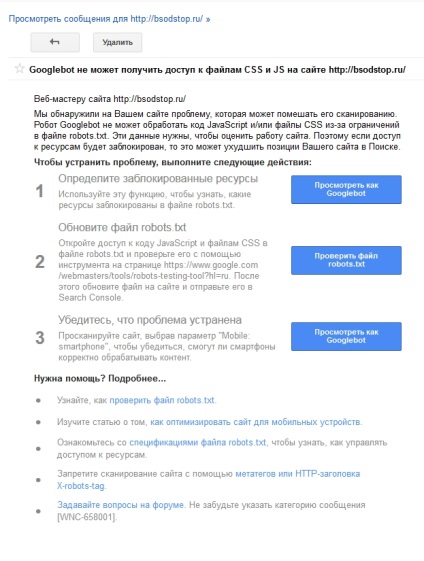

Помилки пов'язані з проблемою доступу до файлів:

Файл robots.txt з інструкціями:

Для початку необхідно зрозуміти яким ресурсам необхідно надати доступ. Для цього:

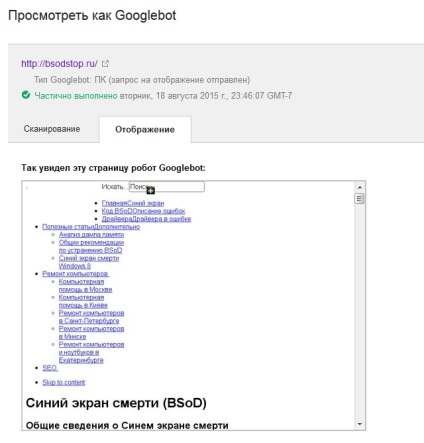

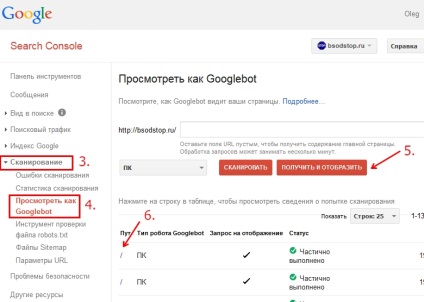

- Заходимо в Google Webmaster Tools.

- Вибираємо потрібний сайт.

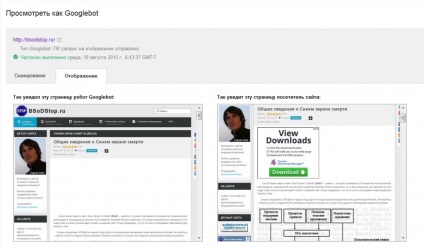

- Переходимо на пункт меню "Сканування".

- Вибираємо вкладений пункт меню "Подивитись як Googlebot".

- Ми залишаємо рядок порожній і тиснемо кнопку "Отримати й відобразити". У цьому случуе відображатися буде головна сторінка.

- Після чого клацаємо на посилання в стовпці "Шлях".

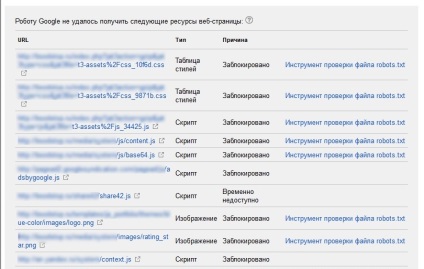

Якщо детально проаналізувати, то для оцінки сайту Google хоче отримати доступ не тільки до файлів js і css, а й до файлів зображень і анімації. У зв'язку з цим найкращим виходом буде повністю відкрити сайт для індексації залишивши в robots.txt тільки наступну інформацію:

А ось уже сторінки, які необхідно закрити від індексації необхідно закрити за допомогою мета-тега:

результати

Після впровадження всіх рекомендацій маємо наступний результат:

Ще однією перевагою даного методу є те, що інструкції в robots.txt мають рекомендаційний характер, в той час як meta = "robots" обов'язкова умова. Ось що з цього питання можна знайти в довідці Google:

Налаштування файлу robots.txt є вказівками, а не прямими командами. Googlebot і більшість інших пошукових роботів дотримуються інструкцій robots.txt, проте деякі системи можуть ігнорувати їх.

І часом в індексі можна зустріти сторінки, які закриті в robots.txt. наприклад:

Також обов'язково перевіряйте відображення мобільної версії сайту. Для цього замість "ПК" необхідно вибрати "Mobile: Smartphone". Але якщо всі вищенаведені дії були зроблені вірно, то і з мобільною версією проблем бути не повинно.

висновок

У висновку хочеться приділити увагу наступним моментам:

- Вплинути на сторонні скрипти ми не можемо. Так наприклад, Googleboot не може отримати доступ до скриптів Adsense знаходяться на стороні самого Google.

- Частина файлів, до яких відкритий доступ, можуть виводитися в списку ресурсів доступ до яких не вдалося отримати з вказаною причиною "Тимчасово недоступно". Думаю, це пов'язано з необхідністю обробки величезної кількості даних, які просто не встигають оброблятися.

Буду вдячний за кожен лайк: