Що таке robots.txt?

Robots.txt (протокол виключення роботів) - вдає із себе звичайний текстовий файл, в якому прописані вказівки для пошукових роботів, які розділи вашого сайту можна індексувати, а які ні. Вірите чи ні, це один з найбільш важливих файлів з точки зору SEO. Наприклад, ви не хочете щоб пошукові системи індексували каталог W- admin. який в основному призначений для внутрішнього використання і не несе будь-якої інформації для пошукового просування.

Як працює robots.txt?

Коли пошуковий робот відвідує ваш сайт, він в першу чергу шукає файл роботс.тхт і сприймає його як інструкцію.

Чим корисний файл robots.txt?

- Якщо ви хочете щоб пошукові системи ігнорували будь-які дубльовані сторінки сайту.

- Якщо ви хочете щоб пошукачі не індексували певні області сайту або весь сайт в цілому.

- Якщо ви хочете щоб роботи не індексували певні файли на вашому сайті (зображення, PDF і т.д.).

- Якщо ви хочете повідомити пошуковим роботам де розташована карта сайту (sitemap.xml).

Створення файлу robots.txt.

Налаштування файлу robots.txt.

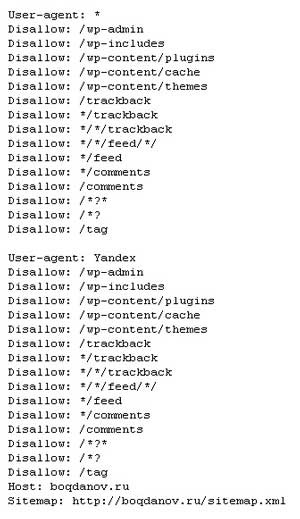

Розберемо настройку на прикладі мого файлу і дізнаєтеся чому я збираюся відредагувати його.

Кожен запис файлу починається з User-Agent. яка позначає, для якого пошукового «павука» виставлені правила. Зірочка, яка ставиться далі (*) означає, що правила виставлені для всіх пошукових роботів. Для Яндекса прийнято вказувати окремий набір правил, (User-agent: Yandex). Тому що тільки для Яндекса вказується розташування карти сайту і дзеркало сайту. Далі з кожного рядка виставляється заборона (Disallow :) або дозвіл (Allow:) для індексації областей сайту. наприклад:

Заборонити Яндексу сканувати каталог wp-admin вашого сайту.

Думаю зрозуміло. Їмо далі.

Що включити в файл robots.txt?

Тут кожен вирішує сам, яку область сайту закривати від індексації. Однозначної відповіді немає. Я, частенько гуляючи по сайтам і блогам, цікавлюся файлом роботс.тхт. У всіх свій правильно налаштований протокол. Тут головне одне, переконатися, що нічого не заважає пошуковим системам індексувати основний вміст вашого сайту. І пам'ятайте, цей файл тільки консультує ботів що індексувати, а що ні. Не всі роботи будуть дотримуватися цих інструкції.

Помилки при використанні роботс.тхт.

- Якщо ви вперше налаштовуєте файл robots.txt. то могли допустити ряд помилок.

- Повністю заборонили ваш сайт до індексації. Коли ви ставите Disallow: / помилково, то ви забороняєте павукам індексувати сайт. Робот приходить, бачить червоне світло і йде. Це призводить до того, що сайт мало того що не оновлюється, так ще і з часом повністю випадає з видачі.

- Не завжди забороняє до індексації. Як я вже згадав вище, для деяких роботів цей файл вже не перешкода, дублікати сторінок все рівно залітають в видачу.

- Вся цінна інформація виставляється напоказ. Існує думка, що будь-хто може відкрити yoursite.com/robots.txt і подивитися всю інформацію про ваших файлах. Такою інформацією можуть зацікавитися хакери.

- Розміщення декількох каталогів в один рядок. Якщо в одну лінію ви виставляєте кілька каталогів на заборону, то файл robots.txt працювати належним чином не буде. Одна лінія - один каталог.

Як перевірити robots.txt?

Після того як ви закінчили настройку файлу, його природно потрібно перевірити.

Перевіряти будемо за допомогою панелі вебмастера Гугл і Яндекс.

Перевірка через Google. Перебуваючи в панелі вебмастера, йдемо по шляху: «Сканування - Інструмент перевірки файлу robots.txt». На цій сторінці відразу подгружается ваш протокол, який можна редагувати. Перевірка на заборону або дозвіл проводиться так само, як в Яндексі.

Що буде, якщо у вас немає файлу роботс.тхт?

Без цього файлу пошукові системи будуть вільно гуляти по всіх каталогах вашого сайту, сканувати та індексувати всі, що там знайдуть.

Чому я збираюся відредагувати файл robots.txt?

Нещодавно я вивчив курс Олександра Борисова "Як стати блогером - тисячником 3.0". До речі, роблю хорошу знижку при покупці по моїй посиланням. Звертайтеся. Так ось, Олександр пропонує свій варіант настройки robots.txt. Ось вона:

Дозволити все і вказати розташування карти сайту - це кращий варіант для більшості веб-сайтів, що дозволяє всім пошуковим системам сканувати та індексувати всі дані. Заборона ставить тільки на основні каталоги:

Вище я говорив, що деякі пошукові системи ігнорують правила, прописані у файлі роботс.тхт. Одним з таких пошукових систем є Google. Хоч закривай, хоч не закривай, він все одно сканує і забирає на індексацію всю інформацію. Так з'являються різного роду дублі, які можуть в кінцевому підсумку призвести до загибелі вашого ресурсу. Після вивчення курсу, я відразу не став налаштовувати файл robots.txt.

Дійсно в видачу потрапили дублі деяких сторінок, хоча я спочатку правильно налаштовував протокол заборони для роботів. Тепер в швидкому порядку буду налаштовувати файл. У цьому курсі Олександр все докладно розповідає, як, що, куди натискати для правильного налаштування. Всі секрети видавати не буду. Скажу одне - це дійсно працює. Якщо ви ще не придбали курс, то раджу найближчим часом зробити це.

Ви просто не можете назвати себе СЕО фахівцем або інтернет-маркетологом, якщо ще не знаєте, що таке файл роботс.тхт. Він визначає, як пошукові системи бачать ваш сайт. Коли налаштовуєте файл robots. txt, віддавайте собі звіт, що саме робите. В іншому випадку ваш сайт може просто зникнути з інтернету, а ви навіть не будете знати чому. Якщо ви не знаєте, як скласти правильний robots.txt. то зверніться за допомогою до фахівця. На цьому у мене все. Удачі в справах!