З одного боку, здавалося б, унікальність матеріалу на сайті не повинна порівнюватися з унікальністю контенту в мережі. Але ось пошуковим роботам так не здається, і їм зовсім не хочеться витрачати свої сили на індексацію різного сміття, до якого якраз і відносяться дублі сторінок з одного проекту. І тому, як би не хотілося, але пошуковики за такі дублі карають ресурс зниженням позицій, а також винятком сторінок з пошуку, і навіть може бути накладено АГС. якщо таких дублів буде занадто багато.

Наступним негативним наслідком присутності дубльованого контенту можна назвати підміну головної сторінки сайту у видачі ПС (пошукових систем) на сторінку-дублікат з подальшим зниженням позицій. І крім цього, перетікання статистичного і посилальної ваги всередині проекту на дублі сторінок сайту, і як підсумок - втрата цієї ваги.

Як можуть виникнути дублікати сторінок, і взагалі, дублікат сайту

Зустрічаються і неповні дублі, в яких інформація скопійована частково. Наприклад, невеликі анонси матеріалів сайту в RSS-стрічці і т.д, дублювання сторінок відбувається завдяки таким анонсів. Те ж можна сказати і про контент з сайдбара, оскільки, він розташований на всіх сторінках проекту і т.д. Неповні дублі в основному характерні для інтернет - магазинів і ідентичних з ними проектів, за рахунок присутності безлічі «наскрізних» елементів в структурі ресурсу.

Які бувають дублі сторінок сайту

1. Головна сторінка ресурсу доступна з www і без них:

Дамо раду: одним з найефективніших способів, як позбутися від дублів сторінок - це не допускати потрапляння їх під індексацію пошуковими ботами. Але таке, на жаль, виходить далеко не у всіх власників сайтів, і не завжди. Найчастіше, web-майстри виявляють дубльовані сторінки вже після занесення їх в індекс пошукових систем.

Найпоширеніші ознаки (причини) появи дублів:

Яким чином, можна виявити дублі контенту

Далі, ми представимо вам 5 способів, як позбутися від дублів сторінок

1. Використовуючи налаштування у файлі robots.txt:

Але якщо на сайті вже досить багато проіндексованих сторінок, то вам буде дуже трудомісткий відшукувати і склеювати дублі сторінок.

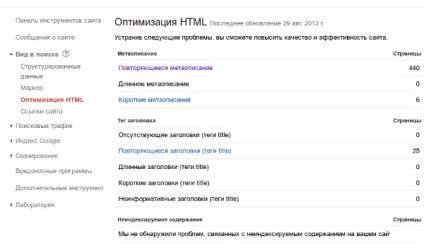

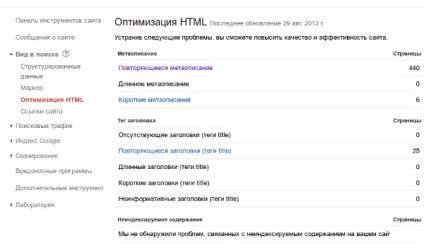

3. Інструменти для web-майстрів

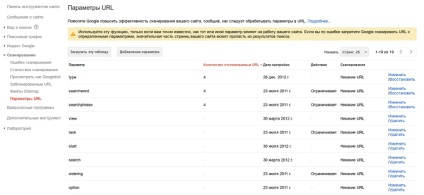

Якщо скористатися функцією «Параметри URL», то це дозволить заборонити Гуглу сканувати сторінки проекту, які мають певні параметри:

Можна також дублі сторінок видалити в ручному режимі:

Але тут необхідно відзначити, що видаляти сторінки можна в тому випадку якщо вони:

- Заборонені для індексування в robots.txt;

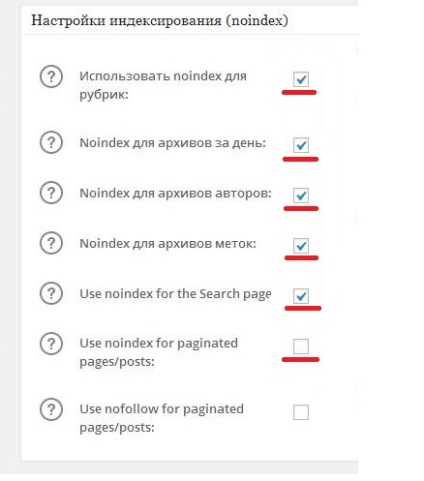

4. Використання метатега noindex

Є одним з найбільш ефективних способів як позбутися дублів сторінок. Точніше, видаляємо назавжди і навіть безповоротно!

Як зазначено в ПС Google, присутність тега «noindex» повністю забороняє індексацію певної сторінки ресурсу.

наприклад:

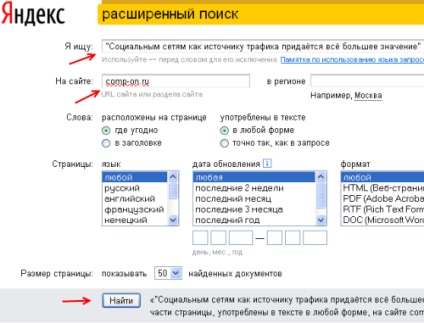

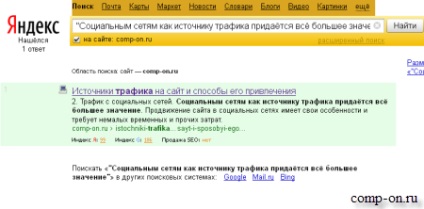

Як відшукати дублі сторінок в ПС Yandex

Для перевірки, чи є дубльований контент в ПС Яндекс, заходимо в розширений пошук:

Якщо ПС видасть тільки одну сторінку, то все О.К! - дублі відсутні. Якщо ж перед вами відкриється кілька сторінок - це дублі! Таким чином, потрібно перевірити ще раз якомога більше статей на вашому сайті.

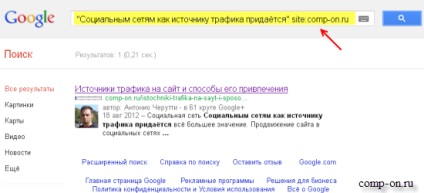

Як відшукати дублі сторінок в ПС Google

У ПС Google все дублі контенту відшукуються майже ідентично, як і в Yandex. Тобто укладаєте фразу в лапки, але обмежуєте пошук тегом «site: mysite.ru»:

Після того як пошук завершено, необхідно натиснути мишкою по напису «Повторити пошук, не опускаючи упущені результати»:

Якщо ви знайшли дубльовані сторінки, то далі рятуєтеся від них, використовуючи один з перерахованих вище способів (можна кілька - для ефективності).

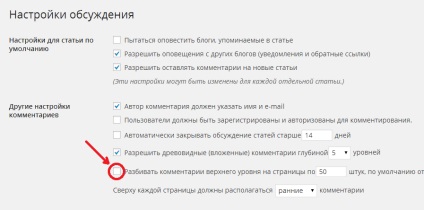

Якщо у вас відкриті для індексування архіви - то, звичайно, і вони будуть посібниками освіти дублів. Закриваються вони в ручному режимі в robots.txt (приклад: Disallow: / arch /). Можна також заборонити індексацію в плагіні All in SEO Pack. Те ж саме робите і з тегами:

Правильна оптимізація свого проекту підвищує його позиції в пошуковій видачі, зменшує витрати на його просування та збільшує дохід з сайту. Тому, всім чудового розвитку і великих заробітків в інтернеті!

До наступних зустрічей